Fausto, per risponderti compiutamente dovrei riproporti le decine e decine di pagine che ho dedicato a questo argomento sul mio libro Tecniche di riconfinazione. Ma siccome mi sembra di ricordare che tu il libro ce l’hai, ti ripropongo qui l’indice dei paragrafi che trattano il tema (è relativo alla nuova edizione che sto scrivendo, ma i paragrafi hanno lo stesso titolo):

| 3. | GEOREFERENZIAZIONE E CORREZIONE DELLE MAPPE CATASTALI | 159 |

|---|---|---|

| 3.1 | LA GENESI DELLA MAPPA D’IMPIANTO | 163 |

| … | ||

| 3.3 | LE MAPPE D’IMPIANTO SU FILE RASTER | 196 |

| 3.3.1 | La situazione delle mappe d’impianto digitali in Italia | 198 |

| 3.3.2 | Perché le mappe raster devono essere georeferenziate | 199 |

| 3.3.3 | La deformazione della mappa d’impianto | 205 |

| … | ||

| 3.5 | LE MAPPE D’IMPIANTO GIÀ GEOREFERENZIATE DALL’AGENZIA | 216 |

| … | ||

| 3.7 | LA GEOREFERENZIAZIONE PARAMETRICA | 301 |

| 3.7.1 | Il “Metodo Tani” | 302 |

| 3.7.2 | L’algoritmo della Parametrica | 307 |

| 3.7.3 | Un esempio concreto | 317 |

| 3.7.4 | Gli errori da non commettere | 338 |

| 3.7.5 | Parametrica VS mappe georeferenziate AdE | 349 |

| 3.7.6 | Validità, limiti e alternative alla Parametrica | 350 |

| La curvatura dei parametri | 350 | |

| Il difetto cartografico | 353 | |

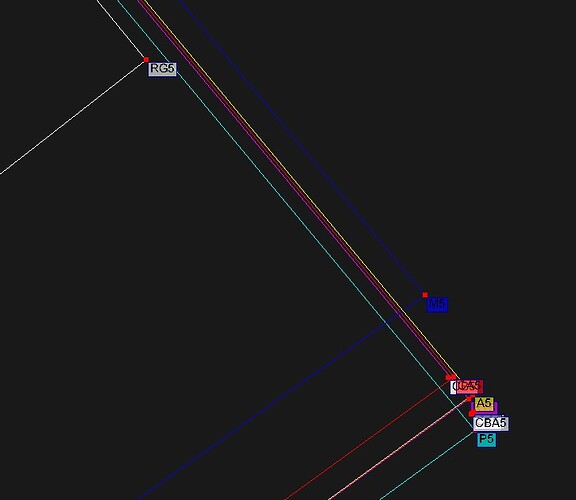

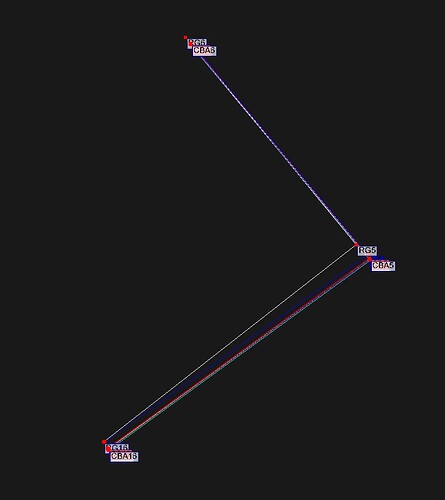

| Scalini e pieghe delle linee georeferenziate | 355 | |

| L’illusione degli algoritmi che agiscono sul raster ricampionato | 363 | |

| … | ||

| 3.11.3 | Le georeferenziazioni polinomiali | 499 |

| 3.12 | QUALE GEOREFERENZIAZIONE USARE? | 502 |

| 3.12.1 | Perché alcune georeferenziazioni non vanno bene? | 504 |

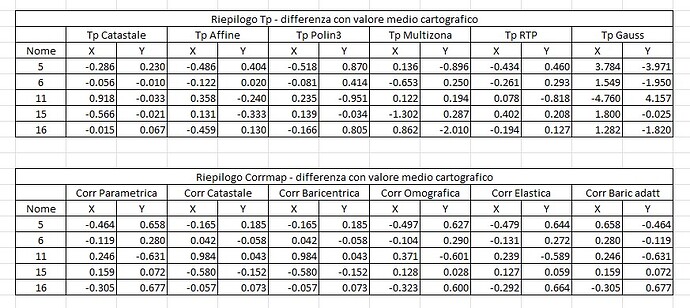

| 3.12.2 | Georeferenziazioni a confronto | 508 |

| 3.12.3 | La soluzione ottimale | 513 |

Leggiti bene (se ti fa piacere, ovviamente) i paragrafi in grassetto. Come vedi, uno di questi si intitola Validità, limiti e alternative alla Parametrica. Questo ti dimostra come io abbia cercato i limiti anche di questa tecnica, oltre che di quelle alternative. E dopo avere analizzato il tutto con grande approfondimento (anche matematico) sono giunto alla mia conclusione. Che, ribadisco, né tu né nessun altro è obbligato a fare propria.

Tornando alla tua domanda, ti rispondo ribaltandotela:

Le conosci tu le deformazioni (isotrope o anisotrope) che ha subìto, su ciascun quadrante parametrico, la mappa d’impianto?

Io no !!!

Nel video da cui siamo partiti, ho visto fare un elenco di tutte le diverse deformazioni che avrebbe subito la mappa presentata. C’è addirittura quella con due frecce di verso opposto dove si dice che una parte della mappa si è stirata verso sinistra mentre l’altra metà si è stirata verso destra.

Siamo a quelle che Carlo Cinelli definisce “seghe mentali”.

Se leggi le pagine del mio libro di cui sopra, troverai che io parto dal presupposto che:

Noi non conosciamo assolutamente come si è deformata la mappa che stiamo utilizzando.

-

Si è solo dilatata o contratta uniformemente?

-

Si è invece dilatata o contratta in maniera disomogenea?

-

Su una zona si è dilatata mentre su un’altra si è contratta?

-

Si è deformata di più sui bordi (più a contatto con l’aria) e meno al centro?

-

Si è deformata di più sul lato destro perché quella zona è rimasta scoperta a lungo, mentre il resto della mappa era coperta dal plico degli altri fogli?

-

È stata “maltrattata” dagli operatori solo (o di più) su certi quadranti e non (o meno) su altri?

Potrei andare avanti con altri casi.

Pertanto, Fausto, se parti dal presupposto che non conosci la deformazione che è intervenuta … qualsiasi algoritmo che pretenda invece di conoscerla è fallace.

Per questo io sostego che il Metodo Tani è il più idoneo, perché parte dai soli incroci parametrici (che sono l’ossatura su cui sono state inserite le stazioni e i punti) e applica una semplice correzione proporzionale.

La tua illusione, da fan dei software, è che, disponendo oggi dei file raster, possiamo applicare tutti i più sofisticati algoritmi internazionali di ricampionatura delle immagini … che tanto le differenze con Tani sono contenute.

Questo, ripeto, è un errore concettuale (al di là delle differenze minime). E io gli errori concettuali cerco, se posso, di evitarli.

Ma tu, come detto, applica pure la Thin Plate Spline se la ritieni idonea. Solo che a quel punto, per coerenza dovresti provare anche le altre georeferenziazioni, ce ne sono a decine (esempio l’Omografia, il Rubber Sheeting, il “raddrizzamento”, ecc.).

Altrimenti, se usi la TPS solo perché ce l’hai nel software, non fai un’analisi compiuta. Ti fidi di quella e basta.

Ti sembra professionale?